Regresi Linear R Studio: Tutorial, Uji Asumsi dan Penjelasan

Dalam kesempatan ini akam kami jelaskan cara atau prosedur, tahapan dan langkah-langkah atau tutorial regresi linear r studio lengkap dengan uji asumsi klasik dan solusinya serta penjelasan atau interpretasi pada setiap tahapan. Regresi linear dengan rstudio dapat dilakukan dengan mudah menggunakan aplikasi open-source ini.

Konsep tentang regresi linear tidak akan kami jelaskan secara rinci disini, sebab sudah kami bahas dalam artikel-artikel sebelumnya:

- Regresi Linear Berganda: Penjelasan, Contoh, Tutorial,

- Pengertian Uji Asumsi Klasik Regresi Linear dengan SPSS,

- Tutorial Cara Uji Regresi Linear dengan Eviews,

- Tutorial Analisis Regresi Dengan Excel,

- Tutorial Uji Regresi Linear dengan STATA – Step by Step, dan

- Regresi Linear Berganda dengan Minitab.

Langkah-langkah Regresi Linear dengan R Studio

Langkah-langkah regresi linear dengan r studio antara lain adalah:

- Persiapan Data,

- Install atau Panggil Library R Studio,

- Import Data ke Dalam Aplikasi R Studio,

- Uji Regresi Linear (Regresi Linear Sederhana atau Regresi Linear Berganda),

- Uji Asumi: Normalitas, Heteroskedastisitas, Linearitas, Multikolinearitas, Autokorelasi (Jika data time series atau runtut waktu), Deteksi Outlier,

- Solusi jika ada masalah asumsi,

- Interpretasi Uji Simultan, Uji Parsial dan Koefisien Determinasi (R Square dan Adjusted R Square),

- Model Prediksi atau Persamaan Regresi.

Persiapan Data

Sebelum masuk pada analisis regresi linear dengan R Studio, pertama kali kita harus mempersiapkan data yang akan digunakan dalam analisis. Kita siapkan menggunakan data dalam excel, seperti contoh data yang dapat anda download DISINI.

Dalam tutorial regresi linear R Studio ini, kita akan melakukan regresi linear variabel bebas X1, X2 dan X3 terhadap Y sebagai variabel terikat. Jumlah sampel sebanyak 75. Tampilan data dalam excel adalah sebagai berikut:

Berdasarkan gambar diatas, tampak bahwa sebagai prediktor antara lain: X1, X2 dan X3. Dan sebagai variabel response adalah Y. Semua data adalah data interval atau rasio (data kuantitatif) sehingga layak menggunakan model prediksi regresi linear berganda. Dikatakan berganda karena terdapat lebih dari 1 variabel bebas atau prediktor.

Panggil Library Dalam R Studio

Langkah berikutnya adalah memanggil library yang akan digunakan dalam analisis, yaitu dengan ketikkan pada console perintah sebagai berikut:

# Memanggil Library

library(lmtest) # Untuk Studentized Breusch Pagan dan Breusch Godfrey

library(car) # Untuk menghasilkan Nilai VIF

library(readxl) # Untuk Import data Dari Excel

library(ggpubr) # Untuk Density Plot

library(MASS) # Untuk Predict: Residuals, Std Res, Stud Res

library(Hmisc) # Untuk Matrix Korelasi

library(corrplot) # Untuk Grafik Matrix Korelasi

Dalam tutorial regresi linear dengan r studio ini, perintah atau syntax diatas juga telah kami beri keterangan (setelah tanda #) kegunaan dari masing-masing library tersebut. Jika gagal dalam memanggil library diatas, maka silahkan install terlebih dahulu library-library tersebut dan pastikan komputer anda terkoneksi dengan internet.

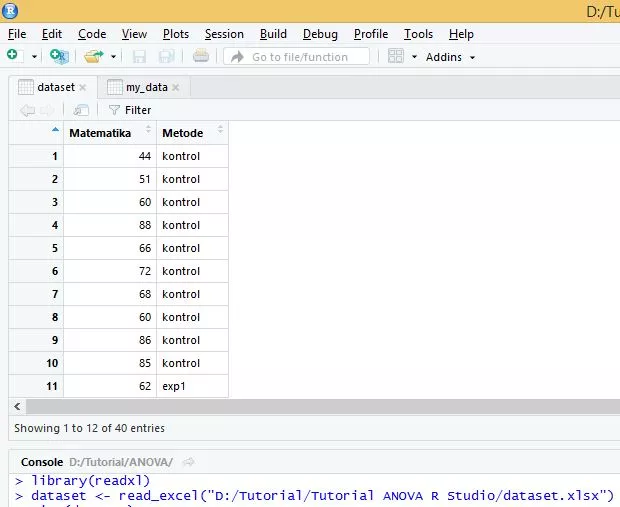

Import Data ke Dalam Aplikasi R Studio

Silahkan ketikkan syntax berikut pada console:

# Import Data Dari Excel

Dataset <- read_excel("Dataset.xlsx")

View(Dataset)

Tampilan pada jendela data akan seperti berikut:

Regresi Linear dengan R Studio

Langkah berikutnya dalam tutorial regresi linear dengan r studio ini adalah melakukan regresi linear dengan perintah sebagai berikut:

# Regresi Linear

mydata=Dataset

reg_lin <- lm(Y ~ X1+X2+X3, data=mydata)

summary(reg_lin)

Coba perhatikan syntax diatas, bahwa kita akan membuat dataframe baru yang diberi nama mydata sebagai replikasi dari Dataset hasil import file excel sebelumnya. Kemudian kita melakukan perintah regresi linear menggunakan fungsi “lm” dimana sebagai prediktor adalah X1, X2 dan X3 dengan response adalah Y.

Data yang digunakan dalam fungsi lm tersebut adalah diambil dari dataframe mydata. Hasil fungsi lm tersebut disimpan dalam vektor yang diberi nama reg_lin. Selanjutnya summary adalah perintah untuk menampilkan reg_lin tersebut sebagai manifestasi dari fungsi lm atau regresi linear.

Tampilannya adalah sebagai berikut:

Sementara output regresi linear r studio diatas kita abaikan dulu karena akan kita jelaskan nanti dibagian paling akhir artikel ini. Selanjutnya kita akan masuk pada tahap uji asumsi klasik pada tutorial regresi linear r studio ini.

Tutorial Uji Asumsi Klasik Regresi Linear R Studio

Seperti yang telah dijelaskan diatas sebelumnya, bahwa uji asumsi klasik yang akan kita lakukan dalam regresi linear r studio ini antara lain: Uji Normalitas, Uji Heteroskedastisitas, Uji Linearitas, Uji Multikolinearitas, Uji Autokorelasi (Jika data time series atau runtut waktu), dan Deteksi Outlier atau Data Pencilan.

Uji Normalitas Pada Regresi Linear R Studio

Uji normalitas yang dilakukan pada regresi linear adalah dengan menggunakan data standardized residual, dimana standardisasi dari residual. Sedangkan residual sendiri adalah selisih antara Y dengan Y Prediksi.

Uji normalitas pada standar residual ini bisa menggunakan metode grafik maupun metode teoritis seperti misalnya uji Shapiro Wilk. Berikut di bawah ini kami akan sampaikan cara melakukan uji normalitas tersebut menggunakan aplikasi r studio.

Uji Normalitas Metode Teoritis

Ketikkan:

## Uji Normalitas Shapiro Wilk

stdres <- stdres(reg_lin) # Menghasilkan Standardized Residuals

stdr<-data.frame(stdres)

View(stdr)

shapiro.test(stdres)

Perintah diatas menunjukkan bahwa kita akan menghasilkan sebuah variabel standardized residual yang diberi nama stdres dimana menggunakan fungsi stdres dari library MASS. Selanjutnya agar dapat dilihat dalam tampilan View, maka dibuat dataframe dengan nama stdr. Terakhir dilakukan uji Shapiro Wilk (shapiro.test) pada variabel stdres yang merupakan standardized residual.

Hasil uji normalitas menunjukkan bahwa nilai W Hitung sebesar 0,97373 dengan p-value sebesar 0,1206 dimana lebih besar dari 0,05 sehingga treima H0 yang artinya standardized residual berdistribusi normal. Sehingga syarat normalitas pada regresi linear dengan r stduio ini terpenuhi.

Uji Normalitas Metode Grafik

Ketikkan:

## Uji Normalitas Grafik

# QQ plot

plot(reg_lin, 2)

# Density plot

ggdensity(stdr, x = "stdres", fill = "red")

Perintah diatas untuk menghasilkan 2 metode grafik uji normalitas yaitu QQ Plot pada Standardized Residual dan Density Plot atau Histogram pada Standardized Residual yang sebelumnya kita hasilkan dengan diberi nama stdres pada dataframe stdr.

Tampilan QQ Plot adalah sebagai berikut:

Tampak bahwa plot-plot menyebar mengikuti garis diagonal dan tidak ada yang menjauh dari garis diagonal tersebut, sehingga secara visual dengan QQ Plot dapat disimpulkan bahwa standardized residual berdistribusi normal.

Tampilan Density Plot adalah sebagai berikut:

Tampak bahwa density plot membentuk menyerupai kurve normal (seperti bel menghadap keatas), sehingga secara visual dengan density Plot dapat disimpulkan bahwa standardized residual berdistribusi normal.

Uji Heteroskedastisitas Pada Regresi Linear R Studio

Uji Heteroskedastisitas disini, kita dapat menggunakan 2 metode yaitu yang pertama adalah metode Uji Glejser dengan cara meregresikan semua variabel bebas terhadap absolut residual. Metode kedua adalah dengan Uji Studentized Breusch Pagan.

Uji Heteroskedastisitas Metode Glejser

Caranya adalah sebagai berikut:

## Uji Heteroskedastisitas Glejser

res <- residuals(reg_lin) # Menghasilkan Residuals

rs<-data.frame(res)

View(rs)

abs_res=abs(res)

glejser <- lm(abs_res ~ X1+X2+X3, data=mydata)

summary(glejser)

Perintah diatas yang pertama adalah menghasilkan variabel residual yang diberi nama res dengan menggunakan fungsi predict residuals pada library MASS terhadap fungsi lm atau regresi yang sebelumnya telah kita simpan dan beri nama sebagai reg_lin.

Agar dapat dilihat tampilan data residual yang diberi nama res tersebut dalam dataframe rs, maka dilakukan View(rs). Selanjutnya rumus abs(res) adalah cara menghitung nilai absolut dari residual yang sebelumnya diberi nama res. hasil perhitungan tersebut dijadikan dataframe dengan nama abs_res.

Selanjutnya analisis Glejser dilakukan dengan menggunakan fungsi lm atau regresi variabel bebas X1, X2 dan X3 terhadap absolut residual atau abs_res. Hasilnya adalah sebagai berikut:

Hasil uji Glejser diatas menunjukkan bahwa sebagian besar atau semua nilai p-value uji parsial (Pr(>|t|) adalah diatas 0,05 dan p value uji F sebesar 0,1731 dimana lebih besar dari 0,05 maka dapat disimpulkan bahwa tidak terdapat masalah heteroskedastisitas. Sehingga dalam tutorial regresi linear dengan r studio ini memenuhi syarat homoskedastisitas, yaitu tidak ada korelasi kuat antara variabel bebas dengan residual.

Uji Heteroskedastisitas Metode Studentized Breusch Pagan

Caranya adalah sebagai berikut:

# Uji Heteroskedastisitas Studentized Breusch Pagan

bptest(reg_lin) # Studentized Breusch Pagan

Syntax diatas menggunakan library dari lmtest, dimana langsung melakukan uji Studentized Breusch Pagan pada fungsi lm sebelumnya yang telah kita simpan dan beri nama reg_lin. Hasilnya sebagai berikut:

Hasil uji Studentized Breusch Pagan menunjukkan bahwa nilai Breusch Pagan sebesar 5,7301 dengan p-value sebesar 0,1255 dimana lebih besar dari 0,05 maka terima H0 maka dapat disimpulkan bahwa tidak terdapat masalah heteroskedastisitas. Hasil ini sejalan dengan hasil uji Glejser sebelumnya diatas.

Uji Linearitas

Uji linearitas diperlukan untuk menilai apakah variabel bebas yang digunakan sebagai prediktor mempunyai hubungan linear dengan variabel respons. Uji linearitas ini dapat menggunakan metode scatter plot antara Y Prediksi (fitted value) dengan residual. Caranya adalah:

## Uji Linearitas

plot(reg_lin, 1)

Perintah diatas untuk menghasilkan scatter plot antara Y Prediksi dengan residual hasil dari fungsi lm sebelumnya yang telah kita simpan dan beri nama reg_lin. Hasilnya adalah:

Plot diatas menunjukkan bahwa setiap plot menyebar merata diatas dan dibawah sumbu 0 serta tidak ada pola tertentu, sehingga dinyatakan tidak ada korelasi antara Y Prediksi dengan Residual. Maka berdasarkan grafik ini, dapat disimpulkan bahwa terdapat hubungan yang linear antara prediktor dengan respons.

Uji Multikolinearitas Pada Regresi Linear R Studio

Uji multikolinearitas pada regresi linear berganda dapat dilakukan dengan menggunakan nilai VIF dan matrix korelasi antar variabel bebas.

Catatan: Multikolinearitas adalah korelasi kuat antar variabel bebas, sehingga asumsi ini hanya dapat terjadi pada kondisi dimana jumlah variabel bebas lebih dari satu, atau yang disebut dengan model regresi linear berganda (multiple linear regression).

Nilai VIF

Ketikkan perintah:

## Uji Multikolinearitas

# Nilai VIF

vif(reg_lin)

Perintah diatas untuk menghasilkan nilai Variance Inflating Factor (VIF) menggunakan library car terhadap hasil uji regresi linear atau fungsi lm sebelumnya yang telah kita simpan dan beri nama reg_lin. Hasilnya adalah:

Nilai VIF diatas pada X1 sebesar 1,021391, VIF dari X2 sebesar 1,046114 dan VUF dari X3 sebesar 1,058963. Berdasarkan nilai tersebut, semua VIF kurang dari 10 maka dapat disimpulkan bahwa tidak terjadi multikolinearitas.

Matrix Korelasi Antar Variabel Bebas

Ketikkan perintah:

# Inter Korelasi Independent Variable

vind <- cbind(mydata[c('X1', 'X2', 'X3')])

rcorr(as.matrix(vind))

corrplot(cor(vind), method = 'number', order = 'alphabet')

Perintah cbind diatas adalah perintah dari library car untuk membuat satu dataframe atau set data yang akan diberi nama sebagai vind yang mana hanya terdiri dari variabel bebas saja (X1, X2 dan X3) berdasarkan dataframe sebelumnya yaitu mydata.

Kemudian rcorr adalah perintah library car untuk membuat matrix korelasi dari set data variabel bebas yang telah diberi nama vind sebelumnya. Kemudian corrplot adalah perintah dari library corrplot yang akan digunakan untuk membuat plot matrix korelasi antar variabel bebas yang sebelumnya dibuat berdasarkan perintah cor dalam library car pada set data vind.

Hasil matrix korelasi perintah rcorr adalah sebagai berikut:

Matrix korelasi diatas menunjukkan bahwa koefisien korelasi antara X1 dengan X2 sebesar 0,08 dengan p value 0,5031>0,05 maka korelasi keduanya tidak signifikan. Nilai absolut koefiisen korelasi keduanya sebesar 0,08<0,9 maka tidak terjadi korelasi kuat antara keduanya.

Korelasi antara X1 dengan X3 sebesar 0,13 dengan p value 0,2482>0,05 maka korelasi keduanya tidak signifikan. Nilai absolut koefiisen korelasi keduanya sebesar 0,13<0,9 maka tidak terjadi korelasi kuat antara keduanya.

Korelasi antara X2 dengan X3 sebesar 0,20 dengan p value 0,0799>0,05 maka korelasi keduanya tidak signifikan. Nilai absolut koefiisen korelasi keduanya sebesar 0,20<0,9 maka tidak terjadi korelasi kuat antara keduanya.

Hasil tampilan dari diagram matrix korelasi diatas adalah sebagai berikut:

Maka berdasarkan matrix korelasi antar variabel bebas diatas, tidak terdapat korelasi kuat antar variabel bebas sehingga disimpulkan bahwa tidak terjadi multikolinearitas. Oleh karena itu asumsi non multikolinearitas pada tutorial regresi linear dengan r studio ini terpenuhi.

Uji Autokorelasi Pada Regresi Linear R Studio

Autokorelasi hanya dapat terjadi pada data time series atau runtut waktu. Jadi analisis ini hanya dilakukan pada data runtut waktu saja. Dalam tutroail regresi linear r studio ini kita asumsikan saja bahwa data yang digunakan ini adalah data time series atau runtut waktu.

Ketikkan perintah:

## Uji Autokorelasi

# Breusch Godfrey Test

bgtest(reg_lin)

# Durbin Watson Test

dwtest(reg_lin)

Syntax diatas menggunakan library dari lmtest, dimana langsung melakukan Breusch Godfrey Test (bgtest) dan Durbin Watson Test (dwtest) pada fungsi lm sebelumnya yang telah kita simpan dan beri nama reg_lin. Hasilnya sebagai berikut:

Hasil uji Breusch Godfrey menunjukkan nilai LM Test sebesar 0,023755 dengan p-value sebesar 0,8775>0,05 maka terima H0 yang artinya tidak terdapat autokorelasi.

Hasil uji Durbin Watson menunjukkan nilai DW Hitung sebesar 1,9813 dengan p-value sebesar 0,4579>0,05 maka terima H0 yang artinya tidak terdapat autokorelasi.

Berdasarkan kedua uji diatas, semuanya terima H0 sehingga dapat disimpulkan bahwa tidak terjadi autokorelasi pada tutorial regresi linear dengan r studio ini.

Deteksi Outlier Pada Regresi Linear R Studio

Untuk mendeteksi adanya data pencilan outlier dapat menggunakan nilai studentized residual. Jika nilai studentized residual sebuah sampel lebih dari 3 maka dapat dikatakan bahwa sampel tersebut adalah pencilan atau outlier. Perintahnya dalam R Studio adalah sebagai berikut:

## Deteksi Outlier

stud_resids <- studres(reg_lin)

studres<-data.frame(stud_resids)

View(studres)

# plot predictor variable vs. studentized residuals

plot(mydata$X1, stud_resids, ylab='Studentized Residuals', xlab='X1')

abline(0, 0)

plot(mydata$X2, stud_resids, ylab='Studentized Residuals', xlab='X2')

abline(0, 0)

plot(mydata$X3, stud_resids, ylab='Studentized Residuals', xlab='X3')

abline(0, 0)

Perintah diatas menunjukkan penggunaan library MASS untuk menghasilkan variabel studentized residual yang diberi nama stud_resids kemudian dijadikan dataframe bernama studres agar dapat dlihat tampilannya dalam console data menggunakan fungsi View.

Sedangkan perintah plot adalah untuk membuat scatter plot untuk menilai sebaran data variabel bebas terhadap studentized residual. Maka hasilnya adalah 3 scatter plot sebagai berikut:

X1 VS Studentized Residual

Scatter plot X1 VS Studentized Residualdiatas menunjukkan bahwa sebaran plot merata diatas dan dibawah sumbu 0 serta tidak ada yang melebihi nilai absolut sebesar 3, sehingga tidak terdapat outlier.

X2 VS Studentized Residual

Scatter plot X2 VS Studentized Residualdiatas menunjukkan bahwa sebaran plot merata diatas dan dibawah sumbu 0 serta tidak ada yang melebihi nilai absolut sebesar 3, sehingga tidak terdapat outlier.

X3 VS Studentized Residual

Scatter plot X3 VS Studentized Residual diatas menunjukkan bahwa sebaran plot merata diatas dan dibawah sumbu 0 serta tidak ada yang melebihi nilai absolut sebesar 3, sehingga tidak terdapat outlier.

Maka berdasarkan ketiga scatter plot diatas dapat disimpulkan bahwa dalam tutorial regresi linear dengan r studio ini tidak terdapat data pencilan atau outlier.

Interpretasi Regresi Linear dengan R Studio

Setelah dipastikan semua uji asumsi terpenuhi, maka selanjutnya adalah menginterpretasikan hasil analisis regresi linear yang sebelumnya telah kita lakukan diatas menggunakan fungsi lm dan diberi nama reg_lin. Jika kita tampilkan kembali sebagai berikut:

Uji Parsial

Hasil uji parsial berdasarkan output diatas adalah:

Pengaruh X1 terhadap Y sebesar -2,017 kali 10 pangkat -04 atau sebesar -0,0002017 dengan nilai absolut t hitung sebesar 0,001<1,96 atau p value sebesar 0,999>0,05 maka terima H0 yang artinya pengaruh parsial tersebut tidak signifkan. Perubahan satu unit X1 akan mengubah Y sebesar -0,0002017, namun karena terima H0 maka estimasi ini tidak bermakna.

Pengaruh X2 terhadap Y sebesar -1,868 kali 10 pangkat -01 atau sebesar -0,1868 dengan nilai absolut t hitung sebesar 1,471<1,96 atau p value sebesar 0,146>0,05 maka terima H0 yang artinya pengaruh parsial tersebut tidak signifkan. Perubahan satu unit X2 akan mengubah Y sebesar -0,1868, namun karena terima H0 maka estimasi ini tidak bermakna.

Pengaruh X3 terhadap Y sebesar -4,325 kali 10 pangkat -01 atau sebesar -0,4325 dengan nilai absolut t hitung sebesar 5,212≥1,96 atau p value sebesar 0,146≤0,05 maka terima H1 yang artinya pengaruh parsial tersebut signifkan. Perubahan satu unit X3 akan mengubah Y sebesar -0,4325, dan karena terima H1 maka estimasi ini bermakna.

Uji Simultan

Nilai F Hitung sebesar 11,44 dengan nilai p-value sebesar 3,317 x 10 pangkat -06 atau sebesar 0,000003317≤0,05 maka terima H1 yang artinya semua variabel bebas (X1, X2 dan X3) secara simultan atau secara serentak berpengaruh signifikan terhadap Y.

Koefisien Determinasi

Nilai R Square sebesar 0,3259 dengan Adjusted R Square sebesar 0,2974, maka dapat besarnya pengaruh semua variabel bebas (X1, X2 dan X3) dalam menjelaskan Y adalah 29,74%. Oleh karena nilai Adjusted R Square sebesar 29,74%<50% maka besarnya pengaruh semua variabel bebas ini termasuk kategori lemah.

Persamaan Regresi Linear

Persamaan regresi linear yang dapat dibentuk berdasarkan nilai koefisien estimasi adalah sebagai berikut:

Y Prediksi = ß0 + ß1 X1 + ß2 X2 + ß3 X3 + ε.

Y Prediksi = 138,6 – 0,0002017 X1 – 0,1868 X2 – 0,4325 X3 + ε.

Berdasarkan persamaan diatas maka dapat dihitung Y Prediksi. Untuk menampilkan Y Prediksi setelah analisis regresi linear dengan r studio adalah sebagai berikut:

## Y Prediksi

y_prediksi=reg_lin$fitted.value

ypred<-data.frame(y_prediksi)

View(ypred)

Syntax diatas adalah untuk menghasilkan sebuah variabel yaitu variabel Y Prediksi dengan nama y_prediksi hasil persamaan regresi berdasarkan fungsi lm yang sudah dilakukan dan disimpan sebelumnya dengan nama reg_lin.

Kemudian ypred adalah dataframe yang dibuat dari variabel y_prediksi agar dapat dilihat tampilan datanya dalam fungsi View.

Menggabungkan Semua Data

Setelah selesai melakukan semua tahapan baik uji regresi linear, uji asumsi dan interpretasi maka kita dapat menggabungkan semua variabel atau data yang dihasilkan dalam tahap-tahap tutorial regresi linear r studio diatas, yaitu dengan perintah sebagai berikut:

## Menggabungkan Semua Data

final_data <- cbind(mydata[c('No', 'Y', 'X1', 'X2', 'X3')], ypred, res, stdres, studres)

View(final_data)

Perintah atau syntax cbind diatas menggunakan library car untuk menggabungkan semua data yang sudah dihasilkan sebelumnya, antara lain: X1, X2, X3, Y, Y Prediksi, Residual, Standardized Residual dan Studentized Residual. Hasilnya adalah sebagai berikut dalam R Studio:

Demikian telah kita jelaskan semuanya cara atau langkah-langkah dan prosedur dalam melakukan analisis regresi linear dengan r studio. Semoga artikel ini bermanfaat.

Daftar Pustaka

Atkinson, A. C. (1985) Plots, Transformations, and Regression. Oxford.

Belsley, D. A., Kuh, E. and Welsch, R. E. (1980). Regression Diagnostics. New York: Wiley.

Breusch, T.S. (1978): Testing for Autocorrelation in Dynamic Linear Models, Australian Economic Papers, 17, 334-355.

B.W. Silverman (1986) Density Estimation for Statistics and Data Analysis. London: Chapman and Hall.

Chambers, J. M. (1992) Linear models. Chapter 4 of Statistical Models in S eds J. M. Chambers and T. J. Hastie, Wadsworth & Brooks/Cole.

Chambers, J. M. and Hastie, T. J. (1992) Statistical Models in S. Wadsworth & Brooks/Cole.

Fox, J. and Monette, G. (1992) Generalized collinearity diagnostics. JASA, 87, 178–183.

Fox, J. (2016) Applied Regression Analysis and Generalized Linear Models, Third Edition. Sage.

Fox, J. and Weisberg, S. (2019) An R Companion to Applied Regression, Third Edition, Sage.

Glejser H (1969). “A New Test for Heteroskedasticity.” Journal of the American Statistical Association, 64(325), 316–323.

Godfrey, L.G. (1978): Testing Against General Autoregressive and Moving Average Error Models when the Regressors Include Lagged Dependent Variables’, Econometrica, 46, 1293-1301.

J. Durbin & G.S. Watson (1950), Testing for Serial Correlation in Least Squares Regression I. Biometrika 37, 409–428.

J. Durbin & G.S. Watson (1951), Testing for Serial Correlation in Least Squares Regression II. Biometrika 38, 159–177.

J. Durbin & G.S. Watson (1971), Testing for Serial Correlation in Least Squares Regression III. Biometrika 58, 1–19.

Mittelhammer RC, Judge GG, Miller DJ (2000). Econometric Foundations. Cambridge University Press, Cambridge.

Patrick Royston (1982). An extension of Shapiro and Wilk’s WW test for normality to large samples. Applied Statistics, 31, 115–124. doi:10.2307/2347973.

Patrick Royston (1982). Algorithm AS 181: The WW test for Normality. Applied Statistics, 31, 176–180. doi:10.2307/2347986.

Patrick Royston (1995). Remark AS R94: A remark on Algorithm AS 181: The WW test for normality. Applied Statistics, 44, 547–551. doi:10.2307/2986146.

R. Koenker (1981), A Note on Studentizing a Test for Heteroscedasticity. Journal of Econometrics 17, 107–112.

T.S. Breusch & A.R. Pagan (1979), A Simple Test for Heteroscedasticity and Random Coefficient Variation. Econometrica 47, 1287–1294

Venables, W. N. and Ripley, B. D. (2002) Modern Applied Statistics with S. Fourth edition. Springer.

W. Kramer & H. Sonnberger (1986), The Linear Regression Model under Test. Heidelberg: Physica

Wilkinson, G. N. and Rogers, C. E. (1973). Symbolic descriptions of factorial models for analysis of variance. Applied Statistics, 22, 392–399. doi:10.2307/2346786.

Wooldridge, J.M. (2013): Introductory Econometrics: A Modern Approach, 5th edition, South-Western College.